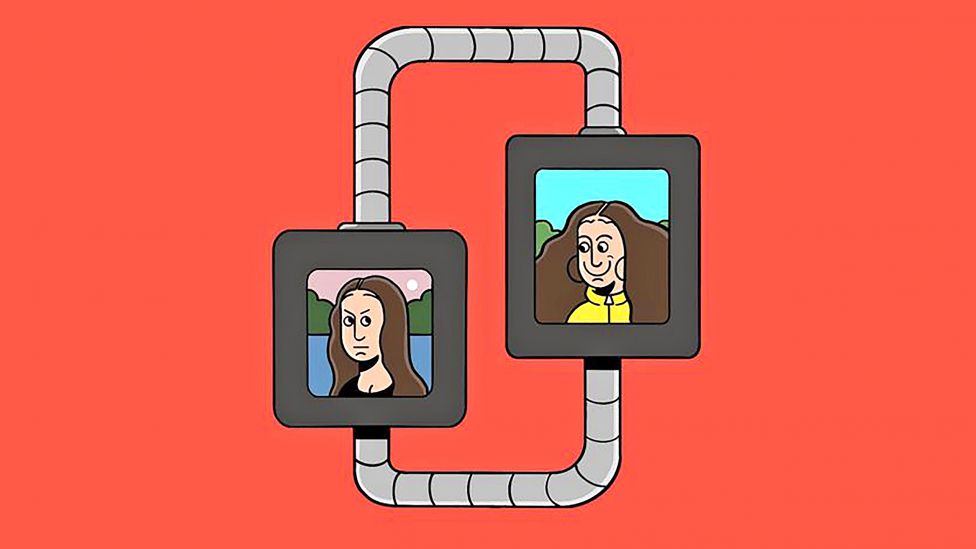

Det er nå mulig å skape falskt, men realistisk innhold med kun et par museklikk.

Dette kan være morsomt: En Tiktok-konto – der blant annet en kunstig Tom Cruise iført en lilla slåbrok synger «Tiny Dancer» til (den ekte) Paris Hilton – har 5,1 millioner følgere.

Dette innebærer en dyptgripende endring for samfunnet vårt, som lenge har sett på bilder, video og lyd som vanntett bevis på at noe er ekte.

Telefonsvindlere trenger nå bare ti sekunder med lyd for å etterligne stemmene til dine kjære i nød. Useriøse KI-genererte versjoner av Tom Hanks og Taylor Swift snakker varmt om tvilsomme produkter på nettet. Falske videoer av politikere sprer seg.

Teknologi muliggjør forfalskning

Det grunnleggende problemet er ikke nytt. Fra trykkpressen til internett har nye teknologier ofte gjort det lettere å spre usannheter eller å utgi seg for å være pålitelig.

Vanligvis har vi mennesker funnet enkle måter å avsløre urent spill på: For mange stavefeil tyder for eksempel på at en e-post kan være et phishing-angrep. Inntil nylig har KI-genererte bilder av mennesker ofte latt seg avsløre av deres merkelige gjengivelse av hender.

Falske videoer og lyd har ofte hatt feil i synkroniseringen. Usannsynlig innhold vekker nå umiddelbart mistanke blant dem som vet hva KI er i stand til å gjøre.

Problemet er at det raskt blir vanskeligere å få øye på forfalskningene. KI forbedres hele tiden, ettersom modellene får tilgang på stadig mer datakraft og større mengder treningsdata.

Lett å ty til dystopier

Kan KI-drevet programvare for å gjenkjenne falskt innhold, om man bygger det inn i nettleserne, identifisere innhold laget av maskiner? Nei, dessverre. Kapp-løpet mellom genereringen og avdekkingen av falskt innhold favoriserer forfalskeren.

Etter hvert vil KI-modeller sannsynligvis kunne produsere forfalskninger som er perfekte ned til den minste piksel – digitale kloner av hvordan et ekte opptak ville sett ut hvis en hendelse virkelig hadde skjedd. Selv det beste avdekkingssystemet ville ikke klart å finne noe feil.

Modeller som drives av regulerte sels-kaper kan bli tvunget til å legge inn et vannmerke, men det vil ikke påvirke svindlere som bruker åpen kildekode-modeller. Dem vil svindlere kunne justere og kjøre hjemme på sine bærbare datamaskiner.

Det florerer av dystopier. Det vil for eksempel være vanskelig å unngå en verden der ethvert fotografi av en person kan gjøres pornografisk av noen som bruker en åpen kildekode-modell, og deretter brukes til utpressing. Det er en taktikk som FBI allerede har advart om.

Kanskje vil hvem som helst være i stand til å produsere en video av en president eller statsminister som kunngjør et første atomangrep, noe som umiddelbart setter verden i alarmberedskap. Det vil trolig florere av svindlere som utgir seg for å være slektninger.

Pålitelig parentes i historien

Likevel vil samfunnet også tilpasse seg forfalskningene. Folk vil lære at bilder, lyd eller video av en hendelse ikke beviser at den har skjedd, like lite som en tegning gjør det. Tiden med åpen kildekodeintelligens (OSINT), med faktasjekking ved hjelp av åpen informasjon, kan være kortvarig.

Nettinnhold vil ikke lenger verifisere seg selv, så hvem som legger ut noe, blir like viktig som hva som blir lagt ut. Forutsatt at pålitelige kilder kan fortsette å identifisere seg på en sikker måte – via nettadresser, e-postadresser og sosiale medier – vil omdømme og opphav bli viktigere enn noen gang.

Det høres kanskje rart ut, men dette har vært tilfellet i det meste av historien. Tiden med pålitelig, masseprodusert innhold har vært unntaket.

Det faktum at folk snart vil slite med å få øye på KIs usynlige hånd, betyr ikke at markedet for ideer er dødsdømt.

Med tiden vil det stort sett være de morsomme forfalskningene som sprer seg.

Publisert i The Economist 18. januar 2024.