Debatten om det kreative potensialet i kunstig intelligens blir ofte formulert i spørsmål om den kan lage en hitlåt eller skape et mesterverk.

Den svenske økonomihistorikeren og musikeren Rasmus Fleischer mener vi bør tenke mer over de eventuelle følgene: For om KI klarer å lage én slager eller ett mesterverk, så vil teknologien være i stand til å produsere millioner. På null tid.

Da vil kulturtilbudet drukne i syntetiske verk skapt av algoritmer som imiterer kunstneriske forbilder. Vi vil få en kulturell hyperinflasjon, hvor kunsten mister verdi.

Arkivavhengig kreativitet

Fleischer belyste disse problemstillingene i et foredrag på seminaret «Artificiell kreativitet och det mänskligas gräns», som ble holdt på Institutet för framtidsstudier i Stockholm tidligere i år.

«Den formen for generativ KI vi nå snakker om, er en fundamentalt tilbakeskuende teknikk. Den bygger på et arkiv av eksisterende kulturprodukter, skapt av mennesker, og så finner den statistiske sammenhenger i dette arkivet. Da får man en modell som gjør det mulig å imitere mønstre som allerede finnes», forklarer Fleischer.

Kreativitet reduseres altså til evnen å lage nytt innenfor rammene av en gitt stil. Det kan man likevel komme ganske langt med. Den amerikanske musikkteoretikeren og komponisten David Cope har i flere tiår brukt algoritmer til å skape «klassiske orkesterverk», deriblant «Beethovens tiende symfoni - The AI Project» (en symfoni Beethoven selv aldri rakk å fullføre), ved å lære en maskin både Beethovens samlede verker og hans kreative prosesser. I fjor fikk komposisjonen sin uroppførelse, fremført av Grove City College Orchestra.

Helt åpne strømmeplattformer vil gi oss millioner nye titler hver eneste dag. Mye vil ligne på spam (elektronisk søppel).

Derfor trenger kulturen sine egne spamfiltre, som kan luke bort syntetisk kunst. Men hvem skal få avgjøre hva som er relevant kultur og hva som er søppel? «Det vekker spørsmål om ytringsfrihet og makt», påpeker Fleischer.

Savner kvalitetsdata

KI-kunsten kan imidlertid bli sin egen verste fiende. Modellene trenger mer og mer data for å kunne trenes til å nå nye funksjonsnivåer, men den tilgjengelige mengden av menneskeskapte verk er begrenset.

Hittil har tilfanget av treningsdata i realiteten vært basert på en enorm piratkopiering av alt som er lagt ut på internett. Nå er stadig flere forfattere, kunstnere, fotografer, journalister og musikere blitt bevisst denne praksisen, og nekter utviklerne tilgang.

Innen KI-industrien snakkes det allerede om en akutt mangel på «kvalitetsdata» – altså tekst, bilder, musikk og annet som holder en standard på nivå med det menneskelige kreatører leverer. Utviklingen av neste generasjon med programvare må baseres på et kulturarkiv hvor annet syntetisk innhold øker i omfang.

En analyse av innholdet i den kommende GPT-5-modellen fra Open AI antyder at kanskje 70 prosent av treningsdataene er syntetiske, meldte Aftenposten i august.

«Habsburger-KI»

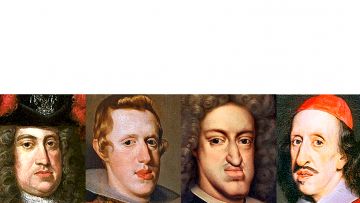

Forskeren Jathan Sadowski omtaler resultatet som «Habsburger-KI», en henvisning til dynastiet som i hundrevis av år satt på flere europeiske troner. Habsburgerne sikret lenge posisjonen gjennom ekteskap mellom nærstående slektninger. Avkommet fikk et karakteristisk «Habsburger-utseende» preget av stor ørnenese, fremskutt hakeparti og hengende underleppe. Mer uheldige utslag var alvorlige sykdommer og infertilitet.

Begrenset genpool F.v. Karl 6. (f. 1685), Filip 4. av Spania (f. 1605), Karl 2. av Spania (f. 1661) og Leopoldo de' Medici (f. 1617) var alle habsburgere og arvet et helt spesielt hakeparti.

KI-varianten definerer Sadowski slik: «Et system som er så tungt trent på materiale fra andre generative KI-er at det blir en innavlet mutant, sannsynligvis med overdrevne, groteske trekk.»

Andre forskere foretrekker uttrykket «modellkollaps». Fenomenet er grundig analysert i en britisk studie publisert i forskningstidsskriftet Nature. Her handler det ikke om syntetisk produksjon av kunst eller musikk, men om leksikonartikler. Syndromene er likevel de samme.

Muterte modeller

De britiske forskerne begynte med å la en språkmodell lage en Wikipedia-artikkel. Deretter ble nye versjoner av modellen som var trent opp på dataene fra forgjengeren, satt i sving med å reprodusere teksten.

Syntetisk data forurenset raskt datasettet, og i den niende versjonen leverte modellen rein-spikket tullball. Artikkelen, som skulle beskrive engelske kirketårn, handlet i stedet om fargene på harehaler.

Selv før kollapsen ble modellen svekket av innslagene med syntetisk tekst. Informasjon som ikke ble repetert i datasettene, falt ut og ble glemt.

«Fullstendig kollaps oppstår til slutt fordi språkmodellene ikke lærer av virkeligheten, men fra den forrige modellens gjengivelse av virkeligheten. Dermed blir feil forsterket i hver versjon», skriver Nature.

«Over tid ender disse feilene med å stable seg oppå hverandre, inntil modellen i utgangspunktet bare lærer feil og ingenting annet», sier Cambridge-forskeren Zakhar Shumailov til tidsskriftet.

En lignende mutasjon kan true kvaliteten på KI-kunsten – om den kannibaliserer seg selv.